アルゴリズム

アルゴリズム 機械学習の落とし穴?局所最適解を理解する

機械学習の目的は、与えられたデータから、将来のデータに対しても有効な予測を行うことができるモデルを構築することです。そのために、モデルの性能を決定づけるパラメータを最適化する必要があります。勾配降下法は、このパラメータ最適化において広く用いられる手法の一つです。勾配降下法は、モデルの予測と実際のデータとの誤差を最小化する方向に、パラメータを少しずつ調整していくという方法です。

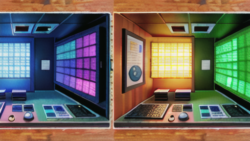

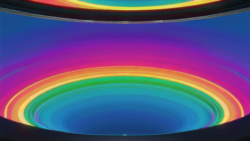

しかし、勾配降下法は、常に最良のパラメータ、すなわち「大域最適解」にたどり着けるとは限りません。なぜなら、勾配降下法は、現在の地点から見て最も急な下り坂を下っていくという戦略をとるため、途中で「局所最適解」と呼ばれる、一見最適に見える地点に捕らわれてしまう可能性があるからです。局所最適解とは、その周辺では最適に見えるものの、全体としてはさらに良い解が存在するような地点のことです。

例えば、山の斜面を下っていくことを想像してみてください。勾配降下法は、最も急な斜面を下っていくため、谷底にたどり着くことができます。しかし、山には複数の谷が存在する場合があり、勾配降下法は、最初にたどり着いた谷底が最も深い谷であるとは限りません。このように、勾配降下法は、初期値や学習率などの設定によって、局所最適解に陥ってしまう可能性があるという課題を抱えています。