ニューラルネットワーク

ニューラルネットワーク 機械学習の落とし穴:プラトー現象

機械学習、特に深層学習の分野では、モデルの学習に勾配降下法という手法がよく使われています。勾配降下法は、モデルの予測と実際の値との誤差を最小化するように、モデルのパラメータを調整していく手法です。

具体的には、勾配降下法はパラメータ空間上の勾配に従って、損失関数を最小化する方向へパラメータを更新していきます。損失関数とは、モデルの予測と実際の値との誤差を表す関数であり、この関数の値が小さいほど、モデルの精度が高いことを意味します。勾配降下法は、この損失関数の勾配、つまり損失関数を最も大きく減少させる方向を計算し、その方向にパラメータを更新することで、損失関数の最小化を目指します。

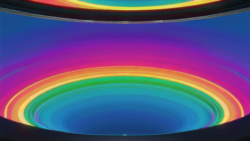

しかし、この勾配降下法は、パラメータ空間上の平坦な領域、すなわち勾配がほぼゼロとなる「プラトー」と呼ばれる領域に陥ることがあります。プラトーに陥ると、たとえ最適なパラメータに到達していなくても、パラメータの更新がほとんど行われなくなり、学習が停滞してしまいます。これは、勾配がほぼゼロであるため、どの方向にパラメータを更新すれば損失関数を減少させられるのかが分からなくなるためです。

プラトー現象は、機械学習の分野における課題の一つであり、様々な解決策が提案されています。